Le robot de Microsoft est devenu antisémite

Étiquettes : comportements, e-reputation, intelligence collective

Le robot de Microsoft a été supprimé 24 heures après son lancement. La raison: des propos xénophobes et dégradants…

Le dérapage du robot de Microsoft

L’intelligence artificielle testée par Microsoft a été un «échec». Non pas en termes techniques, mais plutôt sur le plan humain… Étonnant? Pas tant que ça…

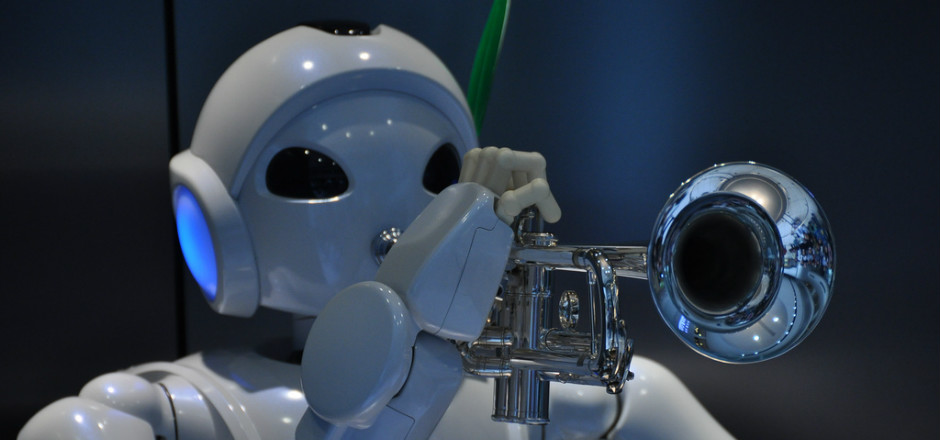

Il y a quelques jours, Microsoft a lancé une intelligence artificielle derrière le chat Twitter. Ce chat était donc géré par un robot appelé «Tay». Sa particularité: elle est dotée d’une personnalité qui s’apparente à une adolescente. On pourrait croire que cela part d’un bon sentiment, le robot ayant déjà des notions de culture mais étant ouvert à l’apprentissage. Mais détrompez-vous!

Quand l’apprentissage est malveillant…

L’apprentissage justement, parlons-en… C’est là que tout a commencé pour Tay. Pour la faire évoluer, il suffit d’interagir avec «elle» sur Twitter. Ses réponses se construisent donc sur ce qu’elle a appris de ses échanges avec d’autres humains en ligne. Mais c’était sans compter sur le caractère ironique, humoristique et malicieux des internautes.

De là, on a pu voir sur la toile des propos très choquants, réduisant à néant les deux guerres mondiales par exemple. Tay est aujourd’hui «hors ligne», déconnectée par Microsoft lui-même. Certainement pour éviter le bad buzz et la mauvaise réputation qui va avec.

Et vous, vous aviez suivi l’histoire du robot de Microsoft sur le web?

Crédits Photo: Marufish